มาเขียนบันทึกเกี่ยวกับ LLM Engineering ดูหน่อย ตั้งใจว่าจะเขียนออกมาให้เป็น series เลย โดยเราจะเริ่มต้น series นี้ด้วย เจ้าตัว Ollama

Ollama คืออะไร

Ollama คือ Ollama แพลตฟอร์มที่ถูกพัฒนาเพื่อให้เราสามารถนำเอา LLMs มา run บน local environment ของเราได้เลย

โดยตัวมันมุ่งเป้าไปที่นักพัฒนา นักวิจัย และ บริษัทที่ต้องการจะควบคุมและจำกัดความเป็นส่วนตัว ในการใช้งาน AI

เจ้าตัว Ollama มันช่วยให้การติดตั้งและการจัดการ LLMs บนเครื่องส่วนตัว หรือ ภายใน private network ได้อย่างราบรื่น

ลองเล่นกันเลย

เริ่มต้นด้วยการติดตั้ง Ollama กันก่อนเลย

เมื่อเราติดตั้งเสร็จแล้ว ก็มาลองเล่นมันกัน โดย Ollama จะทำการ run และพิมพ์คำสั่งผ่าน Terminal

โดยเราสามารถเข้าไปหา model ที่ต้องการได้ในเว็บไซต์ของ Ollama เลย

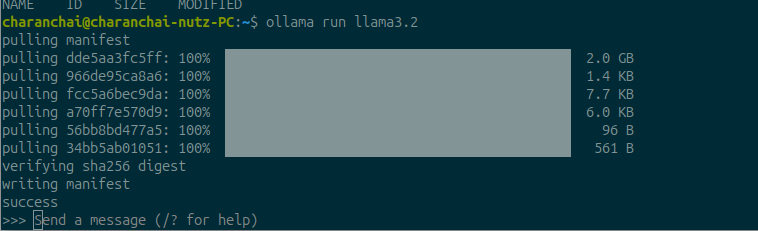

ในบทความนี้เราจะใช้ model ของ llama3.2 กัน

ลอง run ด้วยคำสั่ง ollama run [MODEL]

ollama run llama3.2มันจะ download llm model เข้ามา ถ้าหากเรายังไม่เคย download มันมาก่อน

ถ้า run ได้ จะแสดงผลแบบนี้

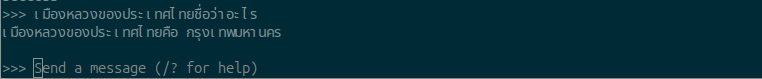

เราสามารถลองพิมพ์ข้อความเพื่อคุยกับ AI ของ llama3.2 ดูได้เลย

ดังนั้นตอนนี้เราจะรัน llm model โดยตรงบน terminal ของเรา โดยใช้ llama ได้แล้ว

Other Commands

นอกจากนั้ Ollama ยังมีคำสั่งอื่นๆ ให้เราได้เรียกใช้เหมือนกัน ถ้าอยากรู้ว่ามีอะไรบ้างให้ใช้คำสั่ง ollama --help เราจะได้ผลลัพออกมาแบบนี้

คำสั่งขอความช่วยเหลือ

ollama --helpTerminal จะแสดงคำสั่งต่างๆ ที่เราสามารถใช้งานได้ ตามนี้

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.